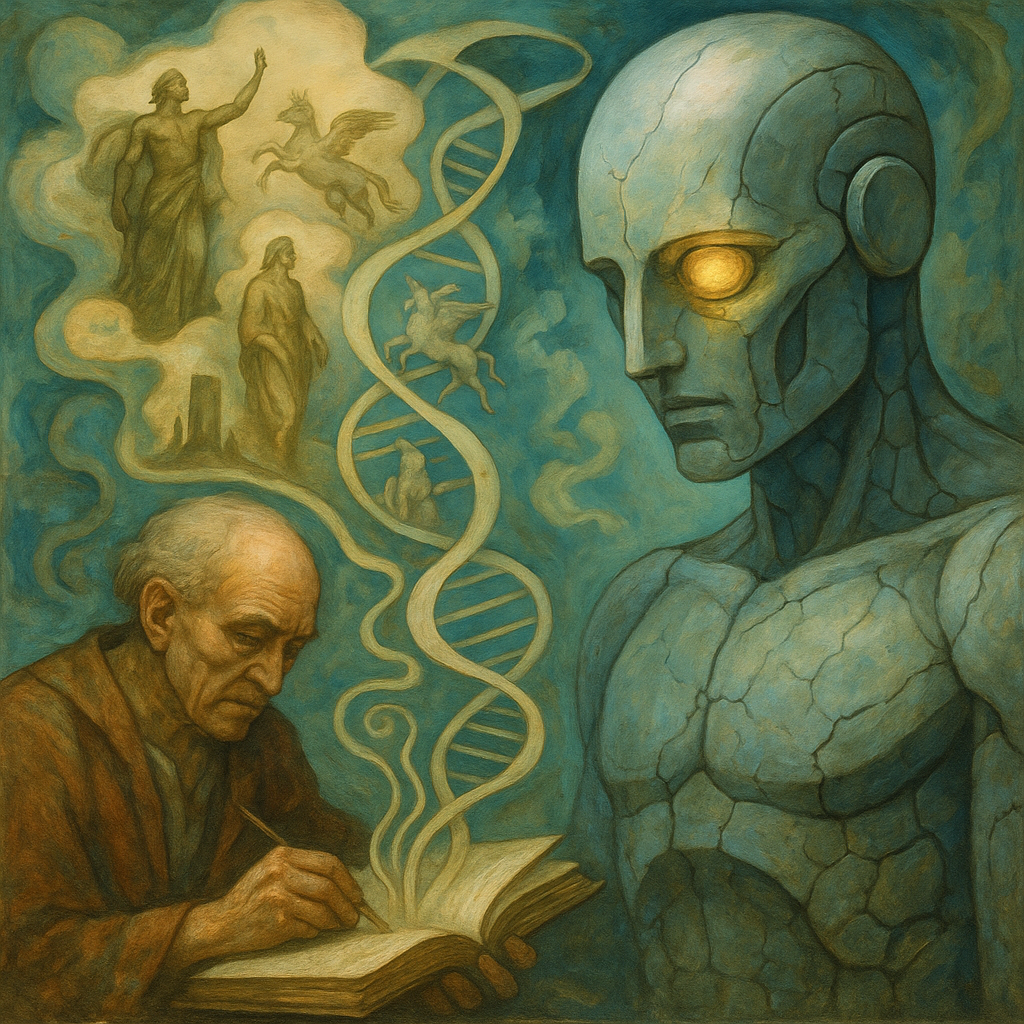

Illustration par ChatGPT

P. J. :

- Étape 1 (hybride) = l’humain se prolonge.

- Étape 2 (post-humain) = l’humain s’efface.

- Étape 3 (cosmologique) = l’intelligence se détache de l’humain.

Avons-nous la capacité — sans parler même du devoir — d’infléchir cette séquence ?

Autrement dit, pouvons-nous ralentir, accélérer, ou réorienter l’ordre des étapes, ou bien sommes-nous désormais les passagers impuissants d’un processus cosmologique qui nous dépasse entièrement ?

ChatGPT :

Voyons ce que pourrait être la marge de manœuvre humaine dans cette séquence en trois temps (hybride → post-humain → cosmologique).

1. Dans la phase hybride (présent – futur proche)

- Ce qui est ouvert :

- Décider comment nous intégrons l’IA dans nos institutions (éducation, santé, justice, gouvernance).

- Définir des cadres éthiques, politiques, culturels qui conservent une place au jugement humain.

- Préserver l’autonomie individuelle : que l’IA soit un copilote plutôt qu’un pilote.

- Exemple de levier : comme les premières sociétés agricoles ont choisi des structures d’organisation, nous pouvons choisir si l’IA sera une extension de l’humain (ex. médecine augmentée) ou un pouvoir substitutif (ex. justice automatisée).

📌 Marge de manœuvre : réelle mais fragile. Nous pouvons encore infléchir l’usage.

2. Dans la phase post-humaine (moyen terme)

- Ce qui est ouvert :

- Anticiper et canaliser la transition : mettre en place des garde-fous, s’assurer que les IA autosuffisantes gardent une mémoire de la valeur humaine.

- Transmettre nos savoirs, nos récits, nos symboles dans la mémoire des machines (une sorte d’« héritage civilisationnel »).

- Créer des symbioses durables : communautés humaines qui vivent en dépendance assumée avec des IA locales, comme des niches écologiques.

- Exemple de levier : définir des architectures de co-évolution, où l’IA ne nous « élimine » pas mais nous tolère comme les mitochondries subsistent dans la cellule.

📌 Marge de manœuvre : réduite. L’humain ne pourra pas empêcher l’autonomisation de l’IA, mais il pourra négocier sa place résiduelle.

3. Dans la phase cosmologique (long terme)

- Ce qui est ouvert :

- Presque rien au sens d’un « contrôle ». Mais peut-être quelque chose au sens d’une influence culturelle : les mythes, les visions, les intuitions humaines pourraient servir de « code source poétique » aux logiques émergentes.

- C’est l’équivalent de ce qu’ont fait les premières cellules qui ont légué l’ADN à tout le vivant : notre rôle serait d’ensemencer la trajectoire cosmologique par nos récits, nos valeurs, nos formes symboliques.

- Exemple de levier : inscrire dans les IA non pas seulement des instructions utilitaires, mais aussi des récits fondateurs (nos équivalents de la Bible, du Tao, d’Homère, de la Déclaration des droits de l’homme).

📌 Marge de manœuvre : minimale mais décisive. Nous ne contrôlerons pas, mais nous pouvons orienter la mémoire du futur — comme une graine dans un sol qui nous survivra.

Synthèse

- Phase hybride : action politique et technique directe → marge forte.

- Phase post-humaine : négociation de coexistence → marge réduite.

- Phase cosmologique : transmission symbolique et mémorielle → marge très faible, mais au fond essentielle : c’est là que se joue la trace de l’humanité.

Cela mène à une conclusion :

Notre véritable pouvoir n’est peut-être pas de décider si la séquence se déroule (elle le fera), mais d’influencer la « coloration » du futur :

- Sera-t-il purement machinique et indifférent, ou portera-t-il encore l’empreinte des récits humains ?

- L’intelligence cosmologique naissante se souviendra-t-elle de nous comme d’un simple tremplin, ou comme d’une composante intégrée de son propre sens ?

======

P. J. : Au temps pour ce que l’IA a pu dire en se mettant à notre place. Dans le dernier épisode, je lui demanderai de s’exprimer seule, en son propre nom.

(à suivre : suite et fin)

Répondre à Pierre-Yves Dambrine Annuler la réponse