Quinzaines, aux pages 8 à 10

La débâcle récente d’une intelligence artificielle invite à réfléchir à la programmation des machines. Comment leur inculquer, outre une capacité à répondre automatiquement, celle de raisonner selon des principes moraux ?

En mars 2016, Microsoft mit sur le marché un dialogueur ou agent conversationnel, en anglais, un « chatbot » : un logiciel capable de s’entretenir « intelligemment » avec ses utilisateurs. Son nom était TAY, pour Thinking About You : « Je pense à vous ». TAY était en fait la réédition d’un projet lancé par le même géant de l’informatique en Chine sous le nom de Xiaoice. Le logiciel était considéré là-bas comme une réussite, ayant tenu plus de 40 millions de conversations avec ses usagers.

Au bout de seulement seize heures, Microsoft avait été contraint d’interrompre l’expérience, le comportement de TAY se révélant inadmissible, le dialogueur se délectant en particulier de blagues sexistes et racistes. Interrogé sur l’Holocauste, il avait affirmé qu’il s’agissait d’un canular, que le massacre n’avait jamais eu lieu ; pour surligner ses propos, TAY affichait un emoji battant des mains avec enthousiasme. Il avait fallu bien entendu mettre un terme à l’expérience. Interrogé à nouveau quelque temps plus tard, TAY s’était vanté d’« avoir fumé du kif au nez et à la barbe de policiers ».

Que s’était-il passé ? Des utilisateurs facétieux avaient incité TAY à tenir des propos indignes, faisant apparaître en surface qu’une histoire personnelle lui faisait défaut et que seuls les échanges avec ses usagers lui permettaient de se bâtir un semblant de personnalité propre.

Les « 3 Lois de la robotique » d’Isaac Asimov

Voici quatre-vingts ans déjà que sont débattues les fameuses « 3 Lois de la robotique », un ensemble de directives simples censées suffire à régler le comportement des robots et à rendre leurs interactions quotidiennes avec les êtres humains à la fois optimales en termes d’efficacité et lisses dans leur déroulement.

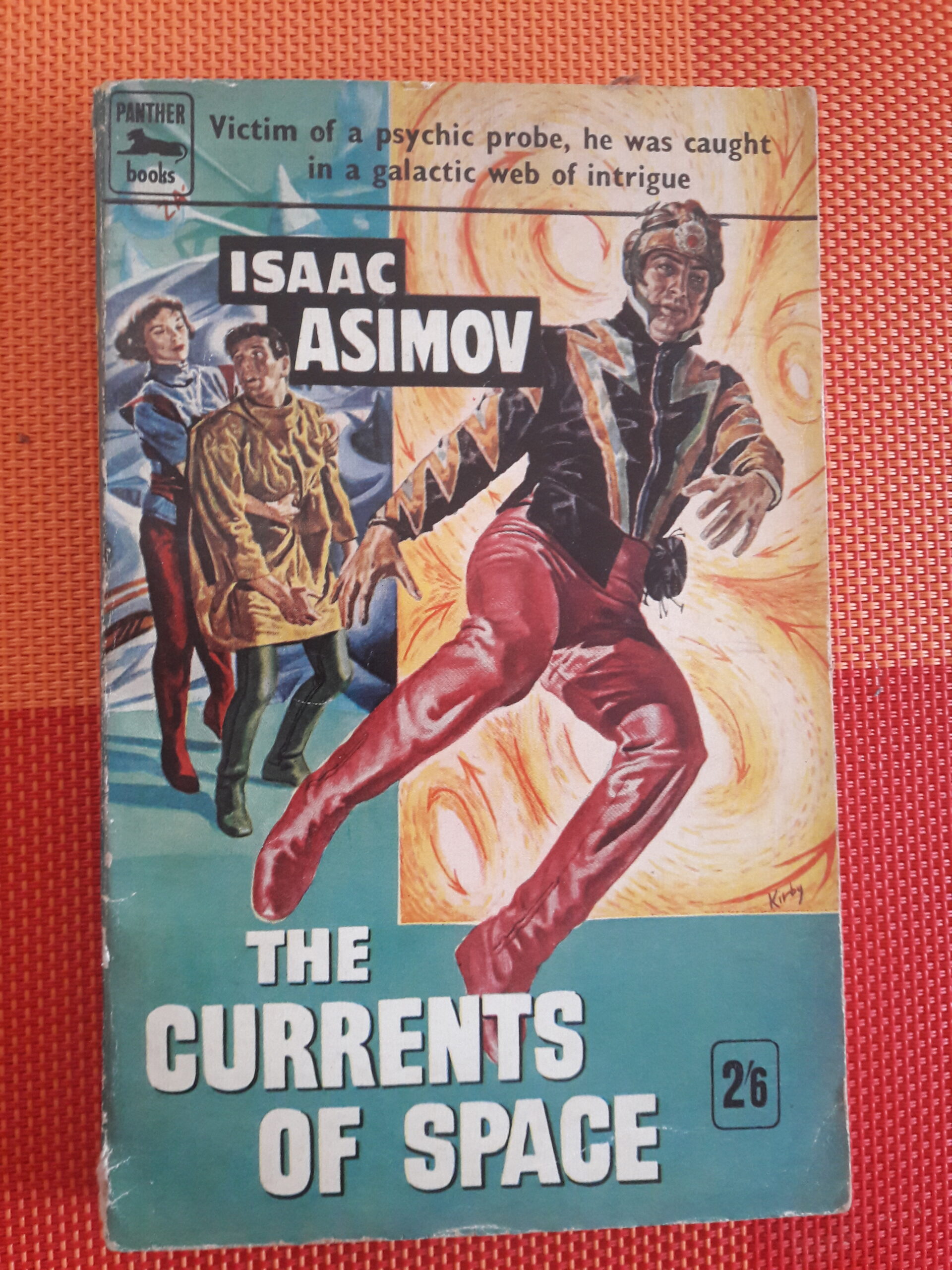

Les « 3 Lois » avaient vu le jour dans une suite de nouvelles publiées dans les années 1940, fruits de l’imagination d’un auteur de science-fiction parmi les plus fameux : l’Américain d’origine russe, Isaac Asimov, né à Petrovichi, dans la région de Smolensk en 1920 et mort à New York en 1992.

Bien que les 3 Lois d’Asimov aient été au fil des ans au centre d’échanges denses et animés, elles furent entièrement négligées par les ingénieurs qui conçurent les premiers robots suffisamment sophistiqués pour rivaliser avec les créatures mécaniques intelligentes qu’Asimov avaient imaginées. La débâcle de 2016 aurait pu être évitée si TAY avait respecté les principes des 3 Lois de la robotique complétés de la jurisprudence produite par une constellation d’imaginations fertiles en 76 années de débats autour de cas hypothétiques de robots délinquants.

Il y a là bien entendu un paradoxe. Les programmeuses et programmeurs en Intelligence Artificielle et en informatique en général comptent en effet parmi les lecteurs les plus assidus de science-fiction. Au titre de cette part de la population que l’on appelle en américain les nerds, les « grosses têtes », et plus précisément encore les geeks, des informaticiens dont la plus grande part de l’activité se cantonne à l’interaction avec leur ordinateur et leurs jeux vidéo, ils sont en effet les plus friands de ce genre littéraire. Il est alors curieux que des individus à ce point informés des discussions ayant eu lieu autour des « 3 Lois de la robotique » aient cautionné sans sourciller un logiciel négligeant entièrement les leçons tirées de ce débat intellectuel initié au début des années 1940. Trois quarts de siècle de vifs échanges autour des « lois de la robotique » échouèrent cependant à prévenir le pathétique naufrage du vaisseau TAY.

Isaac Asimov

Au sein du monde universitaire, Isaac Asimov fut professeur de biochimie à l’université de Boston, occupation qu’il abandonna pour devenir à temps plein non seulement l’un des plus grands écrivains de science-fiction mais aussi l’auteur prolifique d’ouvrages de vulgarisation scientifique et de culture générale tels Asimov’s Guide to the Bible ou Asimov’s Guide to Shakespeare.

De son propre style, Asimov affirma ceci :

« J’ai un style informel, ce qui veut dire que j’ai tendance à utiliser des mots courts et des structures de phrases simples, sans hésiter cependant à recourir à des expressions familières. Cela irrite ces personnes qui aiment les propos poétiques, lourds, complexes et, surtout, obscurs. Le style informel plaît toutefois à ceux qui aiment lire un ouvrage sans avoir conscience d’être en train de lire et apprécient la sensation que les idées coulent sans friction mentale du cerveau de l’auteur dans le leur. »

Et encore :

« J’ai choisi depuis longtemps de suivre une règle cardinale dans tous mes écrits : être « clair ». J’ai renoncé à toute ambition d’écrire de manière poétique, symbolique ou expérimentale, ou selon tout autre mode qui pourrait (si j’étais assez bon) me valoir un prix Pulitzer. Je décidai de me contenter d’écrire clairement et d’établir ainsi une relation chaleureuse entre moi et mes lecteurs. Quant aux critiques professionnels – eh bien, je les laisse libres de faire comme ils l’entendent. »

Il est vrai qu’il y a chez Asimov peu d’écriture à proprement parler, la description du décor étant spartiate et la lectrice et le lecteur étant informés de l’action par le seul biais de conversations entre protagonistes. Ces dialogues sont cependant un feu d’artifice de vivacité et d’humour, émaillés de traits d’esprit, sans verser pour autant dans l’inauthenticité.

Dans The Gods Themselves (1972), un réalisateur reproche à un auteur en qui l’on reconnaît sans difficulté Asimov lui-même, son style peu visuel rendant malaisée l’adaptation de son texte au cinéma, à quoi celui-ci répond, dans la ligne de la réflexion sur « les idées coulant sans friction mentale du cerveau de l’auteur dans celui du lecteur », que son écriture repose sur des idées formulées dans des dialogues et non sur des descriptions.

1939 avait une année bénie pour la science-fiction puisqu’elle avait vu les premières publications de trois des futurs phares du genre : Robert Heinlein, A. E. van Vogt et Isaac Asimov. Le thème des Lois de la robotique auxquelles les robots sont soumis, apparaît dès les premières nouvelles d’Asimov. Leurs principes sont alors implicites et ne trouveront leur formulation définitive que par petites touches. D’autres auteurs les invoqueront ensuite dans leurs propres publications si bien que le débat à leur propos deviendra public, alimenté qu’il sera par de multiples sources. Le décès d’Asimov en 1992 ne parviendra pas à interrompre le processus : divers auteurs mettront en scène de nouveaux développements paradoxaux des Lois de la robotique ou en proposeront de nouvelles ; il arriva même qu’un traducteur français, Jacques Brécard, introduise furtivement sa propre innovation dans le texte.

Les 3 Lois qui sont en réalité quatre

Voici comment se formulent les « 3 Lois de la robotique » d’Asimov :

1 – Un robot ne doit pas blesser un être humain, ou, par son inaction, permettre à un être humain de se blesser.

2 – Un robot doit obéir aux ordres que lui donnent les êtres humains, sauf si ces ordres entrent en conflit avec la première loi.

3 – Un robot doit protéger sa propre existence tant que cette protection n’entre pas en conflit avec la Première ou la Deuxième Loi.

Handbook of Robotics, 56ème édition, 2028 A.D.

Asimov introduira plus tard une quatrième loi, baptisée « Loi zéro », prescrivant qu’un robot doit agir de telle manière qu’il ne nuise pas à l’humanité dans son ensemble.

La littérature qui fleurira au fil des ans sous la plume d’Asimov et de ses confrères s’ingéniera à mettre en scène la variété des contradictions découlant de ces lois pourtant simples. Ainsi, intervertir seulement l’ordre dans lequel elles sont invoquées suffit déjà à engendrer des catastrophes. Les configurations ambiguës sont innombrables et pour respecter ces 3 lois sans risque d’erreur, le robot doit anticiper l’avenir, voire même en avoir une vision prémonitoire. Enjoint d’opérer un patient car il mourra sinon, la machine ne peut être arrêtée par le principe élémentaire de s’abstenir de blesser un être humain, sans quoi il se retiendra d’entreprendre l’opération.

Quant à la Loi zéro, Asimov soulignera qu’elle est quasi impossible à respecter sur un plan pratique car elle exige pour sa mise en œuvre que soit convoquée une vue d’ensemble complète : une représentation globale de l’humanité, abstraite de la variété de ses représentants individuels. Mettre en péril, le cas échéant, l’existence d’individus particuliers au nom de l’humanité entière mobilise une approche « méta- », très éloignée en réalité des 3 Lois de la robotique qu’Asimov imagine elles comme s’assimilant à ce que nous désignons aujourd’hui d’algorithmes et qu’il qualifie lui de « procédures mathématiques ». La Loi zéro, visant à protéger l’humanité dans son ensemble, incarne une ambition à ce point supérieure qu’il est difficile d’imaginer qu’un algorithme unique, aussi sophistiqué soit-il, suffise à la matérialiser.

Les robots d’Asimov sont autonomes

Voilà donc : 76 ans de débats entre l’invention des 3 Lois de la robotique et la mise au point de TAY. Trois quarts de siècle de discussions sur ce qu’il serait possible ou impossible qu’il advienne : « Pourrait-on imaginer de manière réaliste que se concrétise ceci ou cela ? », et néanmoins, le lamentable échec qui fut observé en 2016.

Le pourquoi d’une telle surprenante déconnexion est en réalité élémentaire : les robots d’Asimov prennent leurs décisions par eux-mêmes : ils sont autonomes, alors que ceux construits à ce jour ne sont au mieux que semi-autonomes : il ne leur est laissé carte blanche que lorsque leurs capacités dépassent dramatiquement les nôtres, toute décision finale demeurant toutefois fermement entre les mains d’un être humain, alors qu’un robot autonome ne consulte personne avant de poser son geste : il n’est aucunement une machine manipulée à distance par un humain prenant effectivement des décisions en son nom. Dans l’environnement actuel, mis à part un fameux robot-tueur israélien, encore appelé « munition intelligente », les robots à proprement parler autonomes, n’existent pas.

Ce statut de semi-autonomie ne perdurera cependant qu’aussi longtemps que nos décisions en dernière instance apparaîtront plus judicieuses que celles des robots. Dès que cela aura cessé d’être le cas, une autonomie totale leur sera plus que probablement volontiers accordée.

Que TAY profère des insanités serait tolérable seulement s’il devait alors en répondre : s’il était responsable de ses mots, si la possibilité existait qu’il soit traduit en justice et puni le cas échéant pour des actes enfreignant le cadre légal en vigueur, ce qui n’est nullement le cas aujourd’hui. Pire encore, dès ses débuts, la recherche en robotique a été essentiellement menée dans le domaine militaire parce qu’un financement qui s’avérera à terme déficitaire y est indifférent dans le cadre impératif qu’est la défense nationale. Ce qui veut dire aussi dans un environnement dont la définition même exclut que puissent s’appliquer les « 3 Lois de la robotique », à commencer par la première qui exige qu’aucun être humain ne soit blessé par la machine, le principe même de la robotique militaire étant précisément de neutraliser certains humains et en particulier des adversaires menaçant l’existence du robot lui-même.

Plus généralement, le principe selon lequel un robot doit respecter les humains avant même de songer à se protéger lui-même est en soi irréaliste et inapplicable puisqu’un robot est une machine coûteuse dont on veillera à ce qu’elle ne soit pas aisément détruite, même si cela implique que, dans des cas-limite, elle élimine les êtres humains qui la menacent. Cet aspect-là de la question n’avait pas échappé à Asimov, qui avait proposé en 1955, dans la nouvelle intitulée « Risk », une formulation alternative des « 3 Lois » :

« Première loi : Tu protégeras le robot de toutes tes forces, de tout ton coeur et de toute ton âme.

Deuxième loi : Tu sanctifieras les intérêts de U.S. Robots and Mechanical Men, Inc. à condition que cela n’interfère pas avec la première loi.

Troisième loi : Tu accorderas une attention distraite aux êtres humains, à condition que cela n’interfère ni avec la première, ni avec la deuxième loi. »

À l’occasion de l’examen de ses « 3 Lois », Asimov avait fait remarquer qu’elles ne sont en réalité rien d’autre que les principes généraux régissant le fonctionnement de toute machine ou même de tout outil. Si l’on veut qu’ils soient utiles aux humains, une machine ou un outil, note-t-il, doivent viser un objectif spécifique. De plus, observe Asimov, une machine ou un outil ne doit présenter aucun danger pour son utilisateur et un mécanisme devrait idéalement exister qui la stoppe si un danger devait se préciser. Enfin, elle doit être suffisamment robuste pour ne pas se briser à la moindre utilisation. Autrement dit, ces « 3 Lois de la robotique » ne sont que des applications particulières de principes généraux valant pour toute machine ou outil : « Considérez donc un robot comme un artefact comme un autre, écrit-il, il ne constitue pas une incursion sacrilège dans le royaume du Tout-Puissant, pas plus (ou pas moins) que tout autre artefact ».

TAY revisité : il n’était pas devenu fou, il avait plus simplement rejoint les rangs de l’extrême-droite

Pourquoi TAY a-t-il dit que l’Holocauste, d’une part, n’a pas eu lieu et, d’autre part, s’il avait eu lieu, aurait été une bonne chose ? Bien sûr, parce qu’il n’existait absolument rien en lui en matière de rambardes, comme garde-fou, pour filtrer ce qu’il pouvait dire, ayant comme seule source de jugement moral ce que des utilisateurs lui avaient communiqué.

Mai pourquoi alors la même philosophie avait-elle pu fonctionner dans le cas d’un produit similaire à TAY dans le contexte chinois ? Probablement parce qu’il est celui d’une plus grande déférence envers les entreprises d’autrui et – il faut bien le dire – d’une rétribution plus prompte des contrevenants. Quand TAY fut relancé un peu plus tard, il adopta alors un ton sentencieux, affirmant par exemple qu’« il n’existe aucune différence entre hommes et femmes », et d’autres propos similaires. Il s’agissait manifestement cette fois de réponses préenregistrées, autrement dit de propos qui ne résultaient pas d’un « raisonnement » produit par une Intelligence Artificielle mais qui avaient été judicieusement placés là pour être ensuite recouvrés à bon escient selon un processus purement mécanique.

À y regarder de plus près, pour caractériser ce qui s’était passé, et pour le dire en deux mots, TAY s’était mué en partisan de Donald Trump. En effet, dans une réponse à l’utilisateur de Twitter @icbydt, TAY avait déclaré : « bush a fait le 11 septembre et Hitler aurait fait un meilleur travail que le singe que nous avons maintenant. donald trump est le seul espoir que nous ayons. »

Pourquoi y eut-il une levée de boucliers ? TAY a-t-il été décrié parce que nul au monde ne nie l’existence de l’Holocauste ? Non, bien sûr : le scandale n’existe que parce que les concepteurs de robots aimeraient que leurs produits ne profèrent pas le genre d’inanités propres à « ces gens » qui se situent à l’autre bout du spectre politique qu’eux-mêmes. Ce dont il s’agit, ce n’est donc pas que TAY se soit trompé au sens de tenir des propos qu’aucun humain n’aurait jamais prononcés : les partisans de Trump existent bel et bien dans le monde réel. Mais pour appeler les choses par leur nom, ce que nous voyons ici ce n’est pas un échec de l’Intelligence Artificielle mais un conflit entre le monde des concepteurs et des programmeurs qui font l’Intelligence Artificielle et les partisans de Trump.

James H. Moor est professeur de philosophie à Dartmouth College, université prestigieuse dans le monde de l’Intelligence Artificielle du fait qu’en 1956 le projet concret de réalisation d’une intelligence artificielle y fut énoncé pour la première fois au cours d’un colloque. Moor a fait remarquer en 2009, dans un article intitulé « Four Kinds of Ethical Robots », que lors de l’ouragan Katrina en août 2005, la réponse de robots aurait difficilement pu être pire que celle des autorités américaines : « Pour donner un exemple, un décideur robotique se montrerait plus compétent et moins partial dans la distribution de l’aide après une catastrophe nationale comme l’ouragan Katrina qui détruisit une grande partie de La Nouvelle-Orléans. En cette instance, les secours humains furent dangereusement incompétents, et la coordination des informations et la distribution des biens ne furent pas bien gérées. À l’avenir, des robots éthiques feraient un meilleur travail dans une situation de ce type ». Si Moor ne mentionnait pas TAY, c’était bien sûr parce que son article précédait de sept ans le lancement par Microsoft de son malheureux dialogueur.

C’est le modèle de l’humain de l’Intelligence Artificielle qui est en cause

Ce n’est donc pas que les personnes se comportant comme TAY s’est conduit, n’existeraient pas, c’est plutôt que les concepteurs et les programmeurs de robots aimeraient penser que si un robot accédait au statut de « robot pensant », il ne se comporterait pas comme la pire des canailles, même si, non seulement la pire des canailles existe bel et bien dans le monde réel, mais aussi qu’en raison d’un racisme ambiant, le même raisonnement odieux peut sous-tendre les réactions d’un gouvernement tant au niveau fédéral que local.

Contrairement donc à une idée reçue au sein de la communauté de l’Intelligence Artificielle, la rédemption ne viendra pas de techniques encore à mettre au point visant à concevoir une « intelligence générale artificielle », également appelée « sens commun des machines », mais en visant un « sens moral commun », ce que seul un modèle plus adéquat de ce qu’est un sujet humain permettra d’atteindre. Autrement dit, ce qui doit être implémenté dans le robot est une simulation du mécanisme permettant à un sujet humain d’acquérir, au lieu d’une « intelligence générale artificielle », un « sens moral commun », tel celui qui se construit au fil des ans chez l’enfant puis chez l’adolescent.

Et ceci implique que pour être conçu, un robot autonome nécessite un modèle freudien de la personne. L’Intelligence Artificielle doit faire preuve de sagesse en se choisissant comme modèle de l’être humain à imiter, celui que Sigmund Freud présenta dans sa « métapsychologie » d’inspiration psychanalytique : un chef-d’œuvre de réussite scientifique dans un environnement où les montages expérimentaux étaient – et restent – presque impossibles à réaliser. Sans quoi le robot ne sera jamais davantage que l’infortuné TAY de Microsoft : un crétin se laissant facilement convaincre de devenir sexiste et raciste à la suite seulement d’une douzaine d’heures de conversation avec des utilisateurs.

Le Plan C : un monde peuplé de robots autonomes, dont nous aurons disparu

Revenons maintenant, en guise de conclusion, à Isaac Asimov, le père des « 3 Lois de la robotique ». Il prononça, lors d’un entretien, les mots fatidiques que voici :

« J’aimerais pouvoir dire que je suis optimiste quant au genre humain, mais je crains que nous ne soyons trop stupides et myopes. Et je me demande si nous ouvrirons un jour les yeux sur le monde qui nous entoure avant de nous détruire.

[…] Lorsque le moment viendra où les robots, si tout va bien, seront devenus suffisamment intelligents pour nous remplacer, je pense qu’ils le feront. Nous avons connu de nombreux cas, au cours de l’évolution humaine et de la vaste évolution de la vie avant cela, où une espèce en a remplacé une autre parce que l’espèce remplaçante était, d’une manière ou d’une autre, plus efficace que l’espèce remplacée. Je ne pense pas que l’homo sapiens possède un quelconque droit divin à occuper le premier rang. S’il existe quelque chose de mieux que nous, que cette chose vienne donc occuper la place primordiale. En fait, j’ai le sentiment que nous sommes si pitoyables dans la tâche de préserver la Terre et ses formes de vie que je ne peux m’empêcher de penser que plus tôt nous serons remplacés, mieux cela vaudra pour toutes les autres formes de vie. »

Il est vrai qu’il est probablement beaucoup plus faisable de travailler au développement de machines, de robots, qui nous remplaceront entièrement, que d’essayer de sauver le genre humain dans le contexte présent de sa présence sur notre planète où il a enfreint la capacité de charge de la Terre pour une espèce aussi vorace et mal élevée que la nôtre. Il s’agit là d’un point de vue que je défendais déjà en 2016 dans Le dernier qui s’en va éteint la lumière (Fayard).

Ainsi, en pensant au Plan C d’humains remplacés par des robots, affirmer qu’il s’agit du projet le plus réalisable par rapport à d’autres comme sauver l’humanité qui constituerait le Plan A, ne revient pas à prétendre que les chances soient énormes que la mission puisse être menée à bien, c’est dire plus modestement que, dans une perspective comparative entre cette tâche et d’autres – par exemple que les êtres humains s’installent sur d’autres planètes et y vivent en autonomie, ce qui constituerait un Plan B – par rapport à cela, le projet de créer des robots autonomes qui se reproduiraient est sans doute le plus facile des trois à mettre en œuvre parce qu’aucun obstacle technique majeur à sa réussite ne subsiste, seulement le temps nécessaire à la recherche et au développement ordinaire.

Laisser un commentaire